人工智能模型性能优化策略:提升效率的关键技术解析

- 问答

- 2025-11-06 12:56:59

- 4

在人工智能领域,构建一个高精度的模型只是第一步,如何让这个模型在实际应用中运行得更快、更省资源,即模型性能优化,是决定其能否成功落地的关键,这涉及到从模型本身的结构到其运行环境的全方位考量,提升效率的技术策略可以大致分为几个主要方向。

模型剪枝是一种非常直观且有效的优化技术,其核心思想是移除模型中的冗余部分,一个大型的神经网络模型在训练完成后,其中许多神经元或连接(即权重)对最终输出的贡献微乎其微,甚至可以忽略不计,这就好比一棵枝叶过于茂盛的大树,剪掉一些细小的、不影响主体结构的枝条,反而能让养分更集中地输送到主要枝干上,模型剪枝就是通过分析模型的权重,将那些接近零的、不重要的权重剔除,从而得到一个更小、更紧凑的模型,这个过程能显著减少模型的计算量和参数存储空间,使模型在推理(即使用模型进行预测)时速度更快,占用的内存更少,根据谷歌的研究(来源:Han et al., "Deep Compression: Compressing Deep Neural Networks with Pruning, Trained Quantization and Huffman Coding"),通过精心的剪枝,可以在几乎不损失精度的情况下将模型规模减小一个数量级。

量化是另一项至关重要的技术,在模型的常规训练和初始部署中,通常使用32位浮点数来表示权重和进行计算,这种高精度表示对于保证训练稳定性是必要的,但也带来了巨大的计算和存储开销,量化技术旨在降低数据表示的精度,将32位浮点数转换为8位整数甚至更低的精度,可以想象,用整数运算代替浮点运算,计算速度会快得多,并且存储8位数所需的空间仅是32位数的四分之一,量化分为训练后量化和量化感知训练,前者是在模型训练完成后直接进行转换,简单快捷但可能引起精度下降;后者则在训练过程中就模拟低精度运算的效果,让模型提前适应,从而在最终转换为低精度后能更好地保持准确性,这项技术对于在手机、嵌入式设备等资源受限的边缘设备上部署模型至关重要(来源:Jacob et al., "Quantization and Training of Neural Networks for Efficient Integer-Arithmetic-Only Inference")。

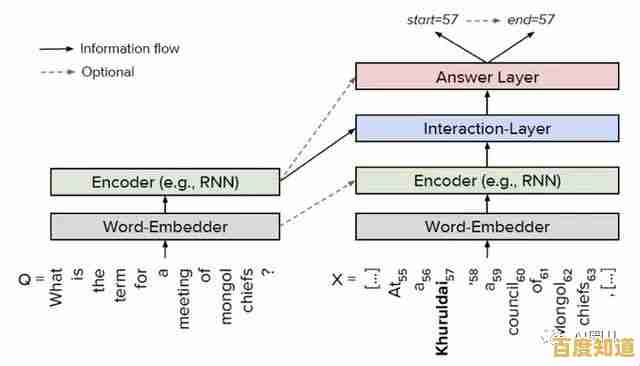

知识蒸馏是一种模仿学习的技术,它试图将一个庞大而复杂的“教师模型”的知识,转移到一个轻量级的“学生模型”中去,教师模型通常拥有很高的精度,但计算成本高昂,知识蒸馏不直接训练学生模型,而是让它学习模仿教师模型的输出行为,特别是教师模型输出的“软标签”(即包含类别间概率关系的预测分布),而不仅仅是真实的硬标签,软标签包含了更多信息,比如模型认为一个图片“有90%是猫,10%是狗”比单纯说“是猫”提供了更多的知识,通过这种方式,小而高效的学生模型能够学会教师模型所掌握的复杂模式和决策边界,从而在保持较高性能的同时,实现推理速度的极大提升(来源:Hinton et al., "Distilling the Knowledge in a Neural Network")。

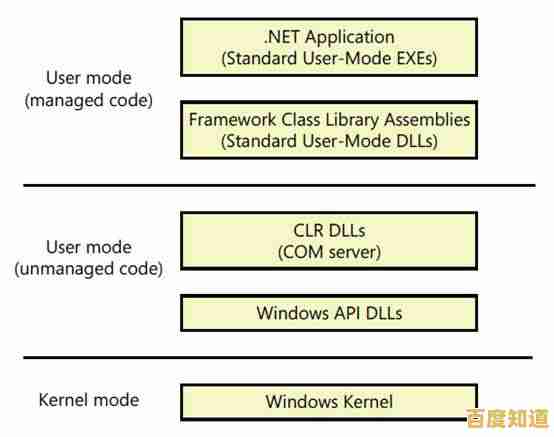

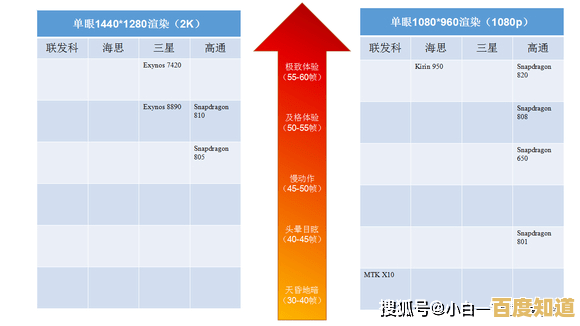

除了对模型本身动手术,优化还可以从模型架构和硬件协同设计入手,使用高效的网络架构是治本之策,近年来,研究者们设计了许多天生就高效的结构,例如MobileNet使用了深度可分离卷积,EfficientNet通过复合缩放模型深度、宽度和分辨率来均衡地提升性能与效率,这些架构从设计之初就充分考虑到了在移动端或资源有限环境下的部署需求,硬件加速是另一个不可或缺的环节,优化后的模型需要搭配专用的硬件才能发挥最大效能,图形处理器(GPU)早已是模型训练的主力,而针对神经网络推理优化的专用芯片,如张量处理单元(TPU)、神经网络处理单元(NPU)等,能够以极高的能效比执行大规模的矩阵运算,利用编译器优化技术(如TVM、TensorFlow Lite)将模型计算图高效地映射到特定硬件上,可以进一步挖掘硬件潜力,减少不必要的内存读写和计算开销。

一个常被忽视但非常实用的策略是早退机制,对于一些分类任务,输入数据在经过网络的前面几层处理后,可能已经能够以很高的置信度做出判断了,早退机制允许模型在中间的某个层(即“退出点”)就输出预测结果,而不必每次都运行完整个网络,这就像一个人阅读文章,有时只看前几段就能抓住核心思想,无需通读全文,通过在网络中设置多个退出点,系统可以根据当前计算的置信度动态决定是否提前结束推理,这对于处理简单样本时节省计算资源非常有效。

人工智能模型的性能优化是一个多层次、多技术的系统工程,从剪枝、量化、蒸馏来精简模型,到采用高效架构和硬件加速来提升计算效率,再到利用早退机制进行动态优化,这些策略往往需要结合使用,根据具体的应用场景、资源约束和性能要求进行权衡和组合,最终实现在保证模型可用性的前提下,最大限度地提升其效率,使其能够更广泛、更经济地服务于现实世界。

本文由势芫华于2025-11-06发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://xian.xlisi.cn/wenda/72890.html